找到

4

篇与

数据抓取

相关的结果

-

运维必备!Kyanos:网络抓包牛B极了 网络抓包是网络运维中不可或缺的一部分。它可以帮助运维人员监控网络流量、排查网络故障、优化网络性能,甚至检测安全威胁。想象一下,当你的服务器突然出现高延迟或服务中断时,抓包工具能够帮助你快速定位问题,是来自某个恶意 IP 的攻击,还是某个服务响应过慢?通过抓包,运维人员可以清晰地看到网络流量的每一个细节,从而迅速采取措施,恢复服务的正常运行。为什么说 Kyanos 是抓包神器? 图片 Kyanos 之所以被称为“抓包神器”,主要得益于其强大的功能和高效的操作。它基于 eBPF 技术,能够直接在内核层面进行数据捕获和分析,这意味着它可以在不影响系统性能的情况下,快速处理大量数据。与传统的抓包工具(如 tcpdump)相比,Kyanos 不仅能够捕获数据包,还能自动解密 SSL 流量,让加密的数据也能一目了然。此外,Kyanos 还支持多种协议(如 HTTP、Redis、MySQL 等),并能够根据进程 ID、容器 ID、请求大小、延迟等多种条件进行过滤,大大提高了运维效率。图片 Kyanos 的主要功能 图片 强大的流量过滤功能:Kyanos 支持基于进程 ID、容器 ID、七层协议信息、请求/响应字节大小、延迟等多种过滤条件。例如,你可以通过以下命令过滤特定进程的流量: ./kyanos watch --pids 1234 高级分析能力:Kyanos 能够聚合捕获的包指标,快速提供关键数据。例如,你可以通过以下命令快速找出最慢的请求: ./kyanos stat --slow --time 5 内核级延迟分析:Kyanos 能够可视化显示数据包在网络卡到内核套接字缓冲区的延迟情况,帮助精确定位问题。例如,你可以通过以下命令查看 HTTP 请求的延迟细节: ./kyanos watch http 自动解密 SSL 流量:Kyanos 能够自动解密 SSL 流量,让捕获的请求和响应以明文形式呈现,大大简化了分析过程。 安装指南 安装 Kyanos 非常简单。以下是详细的安装步骤: 检查内核版本:Kyanos 支持 3.10(从 3.10.0-957 开始)和 4.14 及以上版本的内核。你可以通过以下命令检查你的内核版本: uname -r 下载 Kyanos:从发布页面下载适用于你的系统架构(如 amd64 或 arm64)的静态链接二进制文件: wget https://github.com/hengyoush/kyanos/releases/download/vx.x.x/kyanos_vx.x.x_linux_amd64.tar.gz 解压文件: tar xvf kyanos_vx.x.x_linux_amd64.tar.gz 运行 Kyanos:运行 Kyanos 需要 root 权限,你可以通过以下命令启动它: sudo ./kyanos Kyanos 是一款真正改变了运维工作方式的抓包工具。它不仅功能强大,还非常轻量级,几乎没有任何依赖。通过强大的流量过滤功能、高级分析能力和内核级延迟分析,Kyanos 能够帮助运维人员快速定位和解决网络问题。如果你还在为网络故障排查而烦恼,不妨试试 Kyanos,它可能会成为你运维工作中的“救命稻草”。图片

运维必备!Kyanos:网络抓包牛B极了 网络抓包是网络运维中不可或缺的一部分。它可以帮助运维人员监控网络流量、排查网络故障、优化网络性能,甚至检测安全威胁。想象一下,当你的服务器突然出现高延迟或服务中断时,抓包工具能够帮助你快速定位问题,是来自某个恶意 IP 的攻击,还是某个服务响应过慢?通过抓包,运维人员可以清晰地看到网络流量的每一个细节,从而迅速采取措施,恢复服务的正常运行。为什么说 Kyanos 是抓包神器? 图片 Kyanos 之所以被称为“抓包神器”,主要得益于其强大的功能和高效的操作。它基于 eBPF 技术,能够直接在内核层面进行数据捕获和分析,这意味着它可以在不影响系统性能的情况下,快速处理大量数据。与传统的抓包工具(如 tcpdump)相比,Kyanos 不仅能够捕获数据包,还能自动解密 SSL 流量,让加密的数据也能一目了然。此外,Kyanos 还支持多种协议(如 HTTP、Redis、MySQL 等),并能够根据进程 ID、容器 ID、请求大小、延迟等多种条件进行过滤,大大提高了运维效率。图片 Kyanos 的主要功能 图片 强大的流量过滤功能:Kyanos 支持基于进程 ID、容器 ID、七层协议信息、请求/响应字节大小、延迟等多种过滤条件。例如,你可以通过以下命令过滤特定进程的流量: ./kyanos watch --pids 1234 高级分析能力:Kyanos 能够聚合捕获的包指标,快速提供关键数据。例如,你可以通过以下命令快速找出最慢的请求: ./kyanos stat --slow --time 5 内核级延迟分析:Kyanos 能够可视化显示数据包在网络卡到内核套接字缓冲区的延迟情况,帮助精确定位问题。例如,你可以通过以下命令查看 HTTP 请求的延迟细节: ./kyanos watch http 自动解密 SSL 流量:Kyanos 能够自动解密 SSL 流量,让捕获的请求和响应以明文形式呈现,大大简化了分析过程。 安装指南 安装 Kyanos 非常简单。以下是详细的安装步骤: 检查内核版本:Kyanos 支持 3.10(从 3.10.0-957 开始)和 4.14 及以上版本的内核。你可以通过以下命令检查你的内核版本: uname -r 下载 Kyanos:从发布页面下载适用于你的系统架构(如 amd64 或 arm64)的静态链接二进制文件: wget https://github.com/hengyoush/kyanos/releases/download/vx.x.x/kyanos_vx.x.x_linux_amd64.tar.gz 解压文件: tar xvf kyanos_vx.x.x_linux_amd64.tar.gz 运行 Kyanos:运行 Kyanos 需要 root 权限,你可以通过以下命令启动它: sudo ./kyanos Kyanos 是一款真正改变了运维工作方式的抓包工具。它不仅功能强大,还非常轻量级,几乎没有任何依赖。通过强大的流量过滤功能、高级分析能力和内核级延迟分析,Kyanos 能够帮助运维人员快速定位和解决网络问题。如果你还在为网络故障排查而烦恼,不妨试试 Kyanos,它可能会成为你运维工作中的“救命稻草”。图片 -

安卓高版本无 ROOT 抓包教程 【安卓逆向】无 Root!HTTPS 抓包竟能如此简单?小白也能秒懂 图片 📌 开篇痛点 安卓 7.0 版本(包括)之后,系统不再信任根目录之外的证书。 "想抓包分析 APP 数据,但手机没 Root?HTTPS 加密的包一抓就断网? 别慌!今天教你用『小黄鸟+虚拟机』这对神器,0 门槛破解无 Root 抓包难题!" 🌟 为什么这个方法牛? 无需 Root:解 BL 锁、刷机统统不需要! 安卓全版本通吃:安卓 7.0 以上高版本照样抓! 保姆级教程:跟着做 10 分钟搞定,附避坑指南! 🛠️ 工具准备 小黄鸟 HttpCanary(抓包神器) https://wwb.lanzouf.com/iNZSN026e9qd VMOS 安卓虚拟机(模拟带 Root 的系统环境) https://www.vmos.com/ 工具截图图片 🚀 保姆级操作步骤 第一步:真机安装工具 真机下载安装 小黄鸟 HttpCanary 和 VMOS Pro(虚拟机)。 小黄鸟设置:进入设置 →SSL 证书 → 导出为 System Trusted (.0) 格式,证书会保存在手机 /HttpCanary/cert/ 目录下。 证书导出图片 第二步:虚拟机开“外挂” 启动 VMOS → 新建一个 安卓 7.1 精简版系统(自带 Root 权限)。 导入文件:在虚拟机内用“文件中转站”功能,导入 目标 APP 和 小黄鸟生成的.0 证书。 挂载证书: 用 MT 管理器(需虚拟机内 Root 权限)将证书复制到虚拟机的 /system/etc/security/cacerts/ 目录。 如果提示“只读”,记得在 MT 管理器中 挂载读写权限! 虚拟机操作图片 第三步:抓包实战! 真机启动小黄鸟 → 设置目标应用为 VMOS。 虚拟机内打开目标 APP → 真机小黄鸟自动开始抓包! 抓包成功:所有 HTTPS 流量明文展示,随便看、随便改! 抓包结果图片 ⚠️ 避坑指南 证书复制失败 → 检查虚拟机是否开启 Root 权限,或换用 Root Explorer 操作。 抓不到包 → 确认小黄鸟证书类型是 .0 格式,且 VMOS 网络通畅。 虚拟机卡顿 → 关闭真机后台无关应用,或换用低配版虚拟机系统。 📢 文末 "你学会了吗?赶紧试试看! 评论区 留下你的实战结果,或遇到的坑,博主帮你解答! 转发 给身边的技术宅,一起解锁新姿势!"

安卓高版本无 ROOT 抓包教程 【安卓逆向】无 Root!HTTPS 抓包竟能如此简单?小白也能秒懂 图片 📌 开篇痛点 安卓 7.0 版本(包括)之后,系统不再信任根目录之外的证书。 "想抓包分析 APP 数据,但手机没 Root?HTTPS 加密的包一抓就断网? 别慌!今天教你用『小黄鸟+虚拟机』这对神器,0 门槛破解无 Root 抓包难题!" 🌟 为什么这个方法牛? 无需 Root:解 BL 锁、刷机统统不需要! 安卓全版本通吃:安卓 7.0 以上高版本照样抓! 保姆级教程:跟着做 10 分钟搞定,附避坑指南! 🛠️ 工具准备 小黄鸟 HttpCanary(抓包神器) https://wwb.lanzouf.com/iNZSN026e9qd VMOS 安卓虚拟机(模拟带 Root 的系统环境) https://www.vmos.com/ 工具截图图片 🚀 保姆级操作步骤 第一步:真机安装工具 真机下载安装 小黄鸟 HttpCanary 和 VMOS Pro(虚拟机)。 小黄鸟设置:进入设置 →SSL 证书 → 导出为 System Trusted (.0) 格式,证书会保存在手机 /HttpCanary/cert/ 目录下。 证书导出图片 第二步:虚拟机开“外挂” 启动 VMOS → 新建一个 安卓 7.1 精简版系统(自带 Root 权限)。 导入文件:在虚拟机内用“文件中转站”功能,导入 目标 APP 和 小黄鸟生成的.0 证书。 挂载证书: 用 MT 管理器(需虚拟机内 Root 权限)将证书复制到虚拟机的 /system/etc/security/cacerts/ 目录。 如果提示“只读”,记得在 MT 管理器中 挂载读写权限! 虚拟机操作图片 第三步:抓包实战! 真机启动小黄鸟 → 设置目标应用为 VMOS。 虚拟机内打开目标 APP → 真机小黄鸟自动开始抓包! 抓包成功:所有 HTTPS 流量明文展示,随便看、随便改! 抓包结果图片 ⚠️ 避坑指南 证书复制失败 → 检查虚拟机是否开启 Root 权限,或换用 Root Explorer 操作。 抓不到包 → 确认小黄鸟证书类型是 .0 格式,且 VMOS 网络通畅。 虚拟机卡顿 → 关闭真机后台无关应用,或换用低配版虚拟机系统。 📢 文末 "你学会了吗?赶紧试试看! 评论区 留下你的实战结果,或遇到的坑,博主帮你解答! 转发 给身边的技术宅,一起解锁新姿势!" -

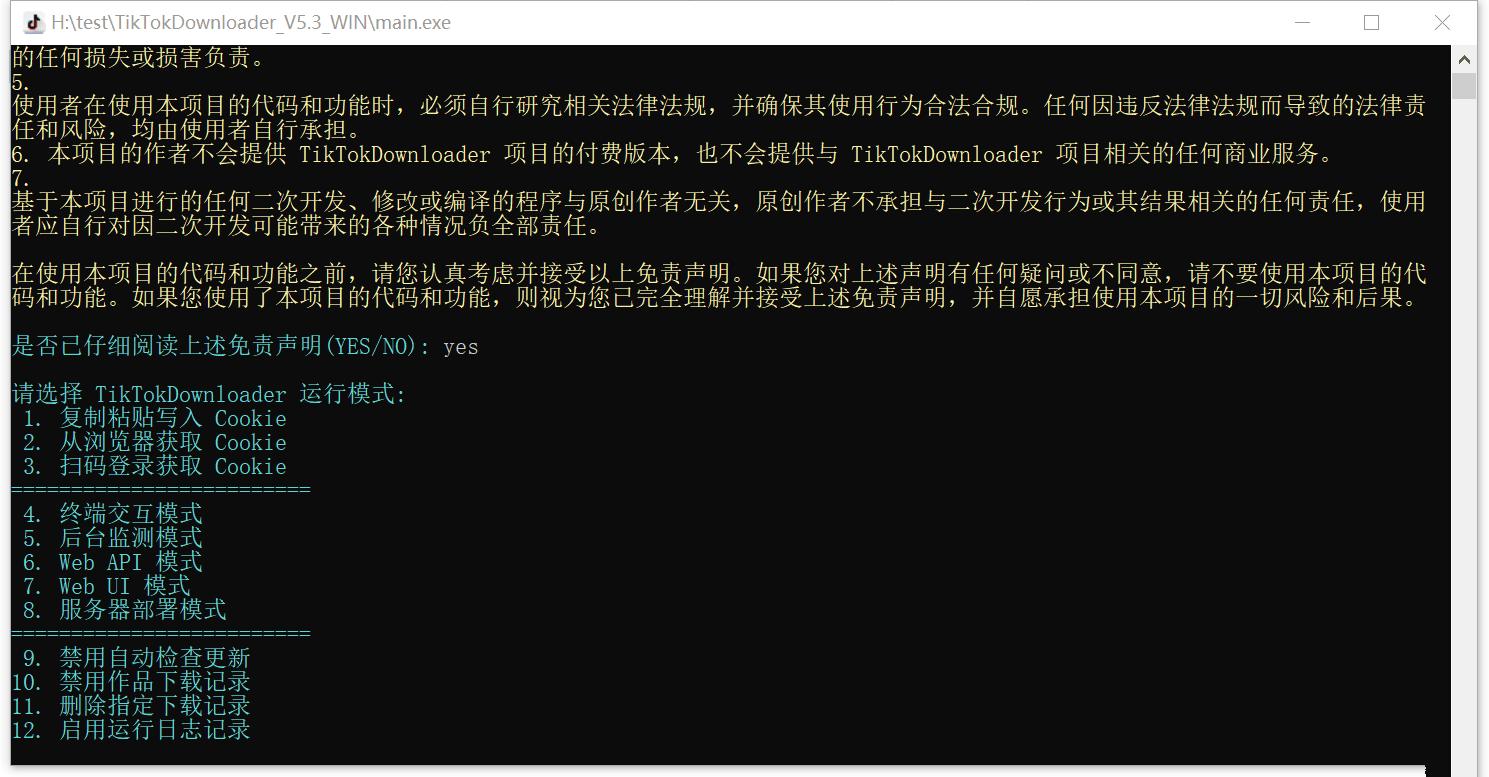

抖音采集下载工具 TikTokDownloader TikTokDownloader 是一个开源项目,功能强大的抖音数据采集工具。它支持多种功能,包括下载无水印视频、图集,采集抖音详细数据,以及获取直播推流地址等。 功能介绍 下载无水印视频/图集:轻松获取高清无水印内容。 批量下载作品:支持批量下载抖音账号发布的视频、喜欢的视频、收藏的作品。 采集详细数据:获取抖音视频的详细数据,方便分析和研究。 自动跳过已下载文件:避免重复下载,节省时间和空间。 持久化保存数据:采集的数据可以持久保存,方便后续查看。 下载封面图:支持下载动态和静态封面图。 获取直播推流地址:可以获取抖音直播的推流地址,方便观看。 Web UI 交互界面:简单易用,双击main.exe即可打开程序,按提示操作即可。 工具预览图 图片 图片 下载地址 隐藏内容,请前往内页查看详情 使用说明 配置 Cookie:使用前需要先配置 Cookie,具体操作请参考离线文档。 操作步骤:双击main.exe打开程序,按提示操作即可进入 Web UI 交互模式。

抖音采集下载工具 TikTokDownloader TikTokDownloader 是一个开源项目,功能强大的抖音数据采集工具。它支持多种功能,包括下载无水印视频、图集,采集抖音详细数据,以及获取直播推流地址等。 功能介绍 下载无水印视频/图集:轻松获取高清无水印内容。 批量下载作品:支持批量下载抖音账号发布的视频、喜欢的视频、收藏的作品。 采集详细数据:获取抖音视频的详细数据,方便分析和研究。 自动跳过已下载文件:避免重复下载,节省时间和空间。 持久化保存数据:采集的数据可以持久保存,方便后续查看。 下载封面图:支持下载动态和静态封面图。 获取直播推流地址:可以获取抖音直播的推流地址,方便观看。 Web UI 交互界面:简单易用,双击main.exe即可打开程序,按提示操作即可。 工具预览图 图片 图片 下载地址 隐藏内容,请前往内页查看详情 使用说明 配置 Cookie:使用前需要先配置 Cookie,具体操作请参考离线文档。 操作步骤:双击main.exe打开程序,按提示操作即可进入 Web UI 交互模式。 -

Python 利用无头浏览器爬虫爬取笔趣阁小说 前言 用户有需求,需要将笔趣阁的小说便捷地保存为文档到本地。笔趣阁有反爬措施,小说内容为 JS 动态生成,Python 的requests库与requests_html已无法满足需求,因此使用类似 selenium 但非 selenium 的无头浏览器爬虫实现小说爬取。 教程步骤 下载安装 Chromium 明确 Chromium 默认安装路径 编写代码 明白爬取参数与注意事项 开始爬取 查看结果 步骤 1. 下载安装 Chromium 下载方式一:官网下载 -> Chromium 下载链接 下载方式二:夸克网盘下载保存 -> Chromium 下载器 下载后,直接双击安装器完成安装。 步骤 2. 明确 Chromium 默认安装路径 安装后,需要明确默认安装的位置,因为代码中会用到。我的电脑用户名为AW,因此被安装在了如下路径:C:\Users\AW\AppData\Local\Chromium\Application\chrome.exe 步骤 3. 编写代码 这段代码中用到的库主要为pyppeteer和python-docx,这两个库需额外下载。 最终代码如下: import asyncio import os from docx import Document from pyppeteer import launch # 禁用自动下载Chromium os.environ["PYPPETEER_SKIP_CHROMIUM_DOWNLOAD"] = "true" async def main(): wordName = "宿命之环1~3章.docx" # Word文件名 netName = "https://www.22biqu.com" # 笔趣阁域名 firstPagePath = "/biqu5251/5259122.html" # 起始页路径 endPagePath = "/biqu5251/5259124.html" # 结束页路径 catchUrl = netName + firstPagePath pageCount = 0 endFlag = False while True: try: doc = Document(wordName) except: doc = Document() browser = await launch(executablePath=r'C:\Users\AW\AppData\Local\Chromium\Application\chrome.exe', headless=True) page = await browser.newPage() await page.goto(catchUrl) element = await page.querySelector('h1.title') if element: text = await page.evaluate('(element) => element.innerText', element) doc.add_heading(text, level=1) else: print('Element not found.') content_element = await page.querySelector('#content') if content_element: paragraphs = await content_element.querySelectorAll('p') for paragraph in paragraphs: text = await page.evaluate('(p) => p.innerText', paragraph) doc.add_paragraph(text) else: print('Content element not found.') element = await page.querySelector('#next_url') next_url = "" if element: next_url = await page.evaluate('(element) => element.getAttribute("href")', element) catchUrl = netName + next_url else: print('Element not found.') await browser.close() doc.save(wordName) if endFlag: break pageCount += 1 print("已完成页码" + str(pageCount)) if next_url == endPagePath: print("匹配到结束链接:" + str(endPagePath)) print("即将结束") endFlag = True asyncio.run(main())步骤 4. 明白爬取参数与注意事项 在使用上述代码时,需要注意以下参数: wordName:爬取后 Word 保存的名称,建议爬什么就取什么名,且加上多少章到多少章。 firstPagePath:起始页路径,比如从《宿命之环》第 3 章开始爬起,则路径为/biqu5251/5259124.html。 endPagePath:结束页路径,建议不要与起始页隔得太远,否则 Word 文件会因字数过多而卡顿。建议分章节爬取。 步骤 5. 开始爬取 设置好参数后,直接运行代码即可。爬取完成后,小说将以 Word 文档形式保存到本地。 步骤 6. 查看结果 打开保存的 Word 文件,章节标题和内容将整齐排列,还可通过章节导航快速定位。 结语 此教程适用于 Python 初学者,后续可优化为 PyQt 程序,提升用户体验。

Python 利用无头浏览器爬虫爬取笔趣阁小说 前言 用户有需求,需要将笔趣阁的小说便捷地保存为文档到本地。笔趣阁有反爬措施,小说内容为 JS 动态生成,Python 的requests库与requests_html已无法满足需求,因此使用类似 selenium 但非 selenium 的无头浏览器爬虫实现小说爬取。 教程步骤 下载安装 Chromium 明确 Chromium 默认安装路径 编写代码 明白爬取参数与注意事项 开始爬取 查看结果 步骤 1. 下载安装 Chromium 下载方式一:官网下载 -> Chromium 下载链接 下载方式二:夸克网盘下载保存 -> Chromium 下载器 下载后,直接双击安装器完成安装。 步骤 2. 明确 Chromium 默认安装路径 安装后,需要明确默认安装的位置,因为代码中会用到。我的电脑用户名为AW,因此被安装在了如下路径:C:\Users\AW\AppData\Local\Chromium\Application\chrome.exe 步骤 3. 编写代码 这段代码中用到的库主要为pyppeteer和python-docx,这两个库需额外下载。 最终代码如下: import asyncio import os from docx import Document from pyppeteer import launch # 禁用自动下载Chromium os.environ["PYPPETEER_SKIP_CHROMIUM_DOWNLOAD"] = "true" async def main(): wordName = "宿命之环1~3章.docx" # Word文件名 netName = "https://www.22biqu.com" # 笔趣阁域名 firstPagePath = "/biqu5251/5259122.html" # 起始页路径 endPagePath = "/biqu5251/5259124.html" # 结束页路径 catchUrl = netName + firstPagePath pageCount = 0 endFlag = False while True: try: doc = Document(wordName) except: doc = Document() browser = await launch(executablePath=r'C:\Users\AW\AppData\Local\Chromium\Application\chrome.exe', headless=True) page = await browser.newPage() await page.goto(catchUrl) element = await page.querySelector('h1.title') if element: text = await page.evaluate('(element) => element.innerText', element) doc.add_heading(text, level=1) else: print('Element not found.') content_element = await page.querySelector('#content') if content_element: paragraphs = await content_element.querySelectorAll('p') for paragraph in paragraphs: text = await page.evaluate('(p) => p.innerText', paragraph) doc.add_paragraph(text) else: print('Content element not found.') element = await page.querySelector('#next_url') next_url = "" if element: next_url = await page.evaluate('(element) => element.getAttribute("href")', element) catchUrl = netName + next_url else: print('Element not found.') await browser.close() doc.save(wordName) if endFlag: break pageCount += 1 print("已完成页码" + str(pageCount)) if next_url == endPagePath: print("匹配到结束链接:" + str(endPagePath)) print("即将结束") endFlag = True asyncio.run(main())步骤 4. 明白爬取参数与注意事项 在使用上述代码时,需要注意以下参数: wordName:爬取后 Word 保存的名称,建议爬什么就取什么名,且加上多少章到多少章。 firstPagePath:起始页路径,比如从《宿命之环》第 3 章开始爬起,则路径为/biqu5251/5259124.html。 endPagePath:结束页路径,建议不要与起始页隔得太远,否则 Word 文件会因字数过多而卡顿。建议分章节爬取。 步骤 5. 开始爬取 设置好参数后,直接运行代码即可。爬取完成后,小说将以 Word 文档形式保存到本地。 步骤 6. 查看结果 打开保存的 Word 文件,章节标题和内容将整齐排列,还可通过章节导航快速定位。 结语 此教程适用于 Python 初学者,后续可优化为 PyQt 程序,提升用户体验。